LABORATORY

[ Bigdata&Machine Learning ]

#1 overview

1985년부터 2016년까지 각 국의 기본 데이터를 토대로 자살율에 대한 몇 가지 기본적인 분석을 수행 합니다.

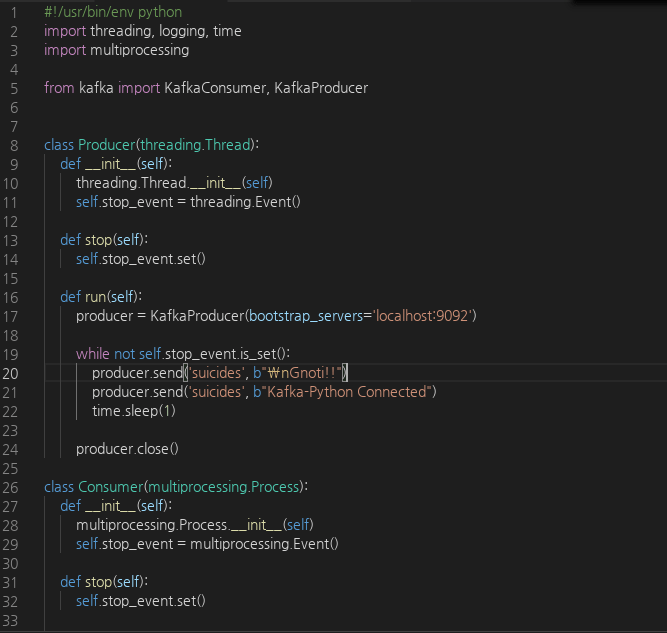

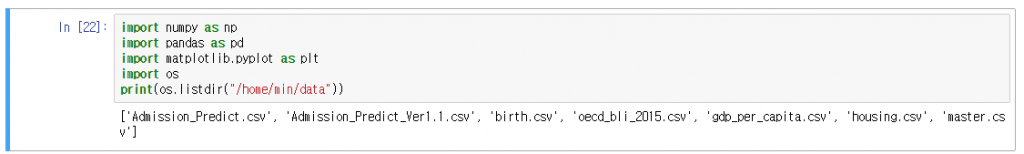

#2 prepare lib

분석을 위한 라이브러리를 준비합니다

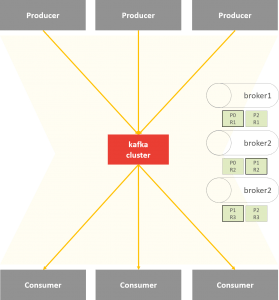

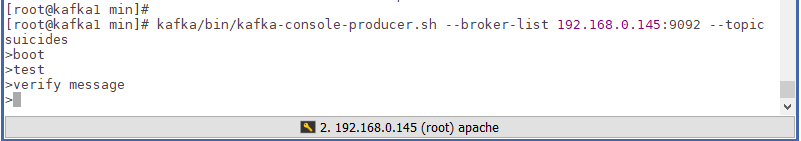

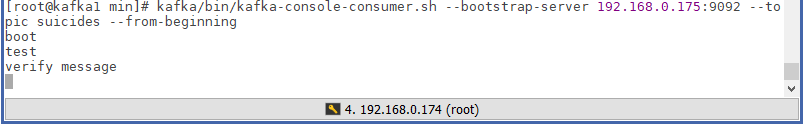

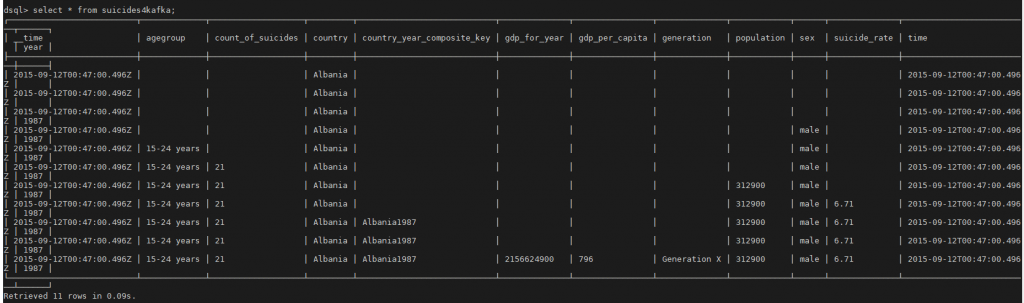

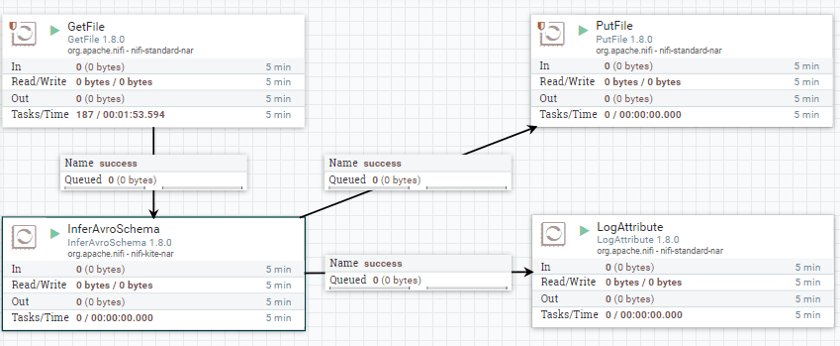

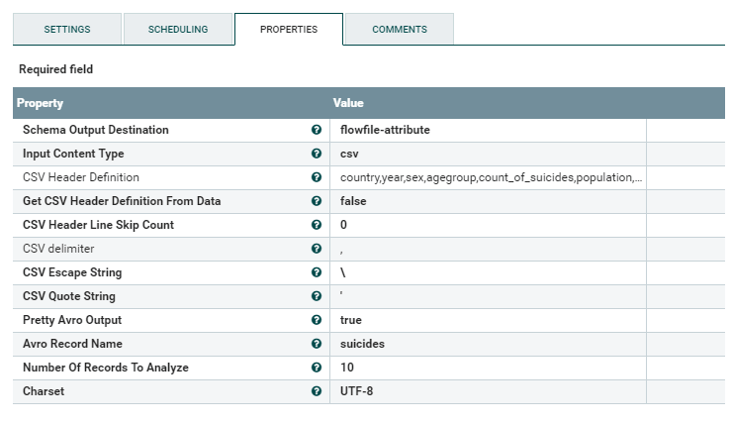

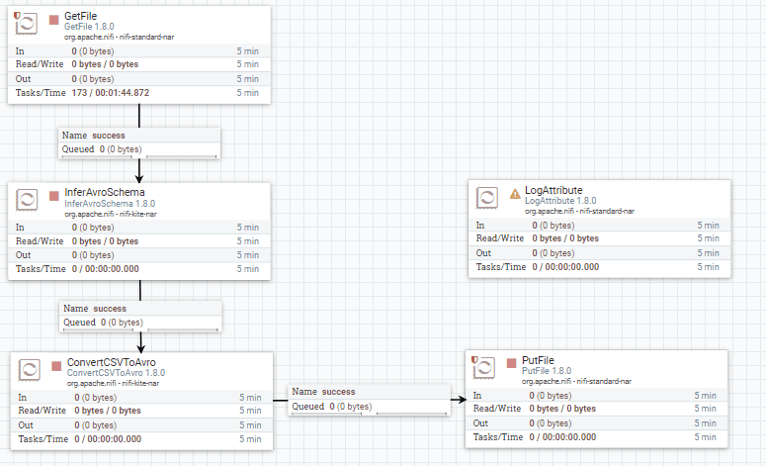

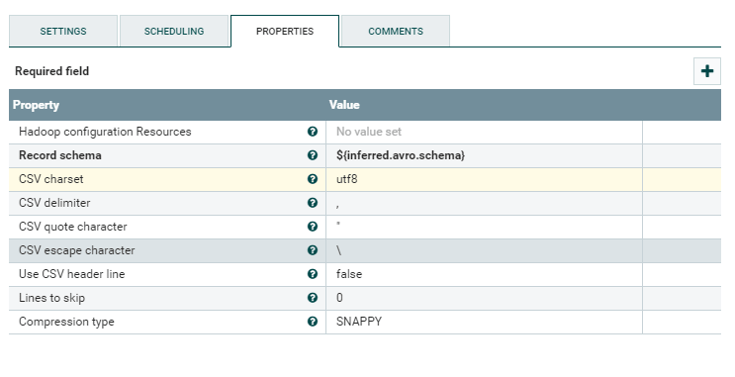

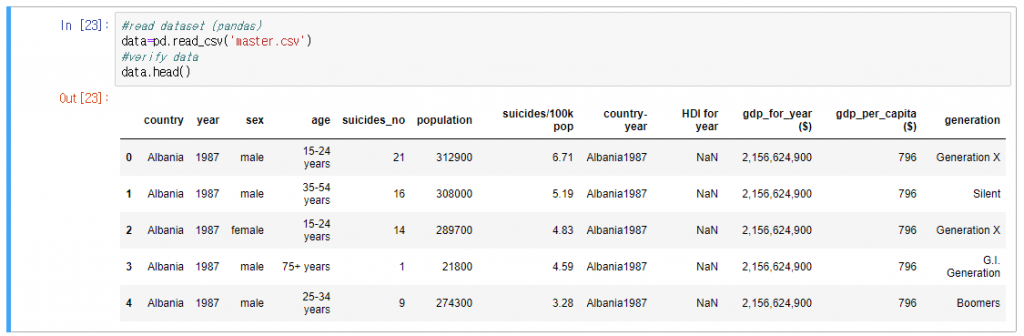

#3 prepare data

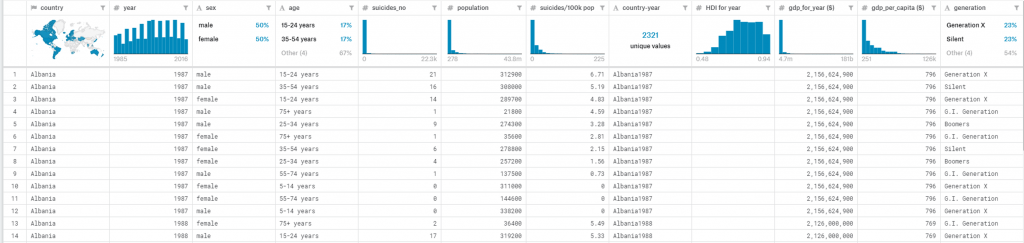

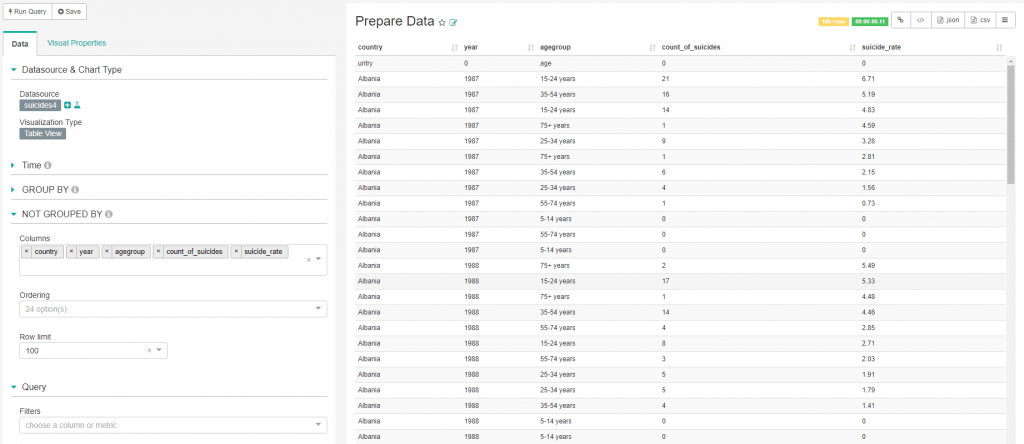

#3.1 데이터셋의 내용을 확인합니다.

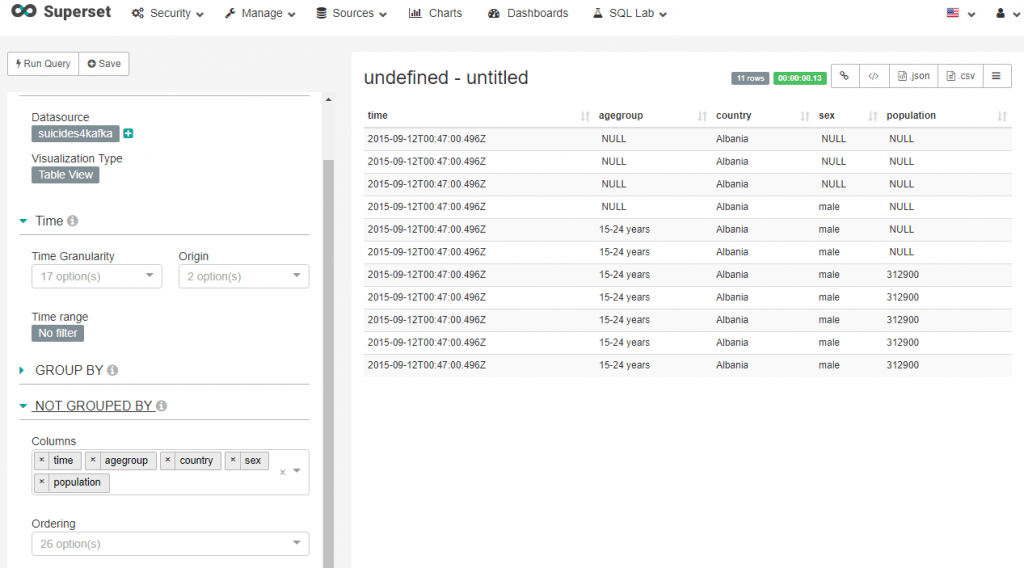

#3.2 Superset을 통해 확인합니다.

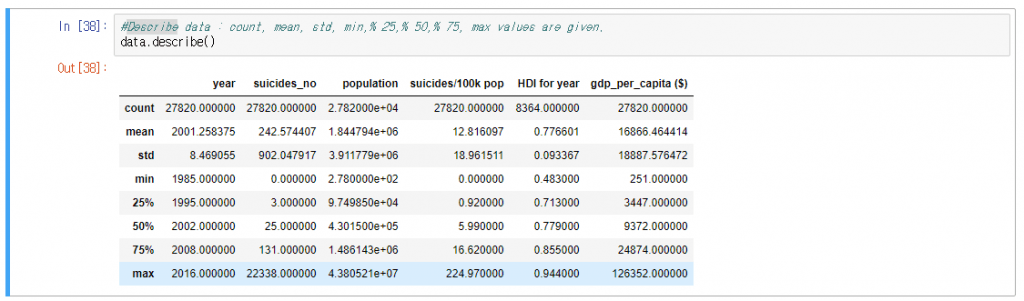

#4 Describe data

NaN 값을 제외하고 데이터 집합의 분포의 중심 경향, 분산 및 모양을 요약하는 설명 통계를 생성합니다.

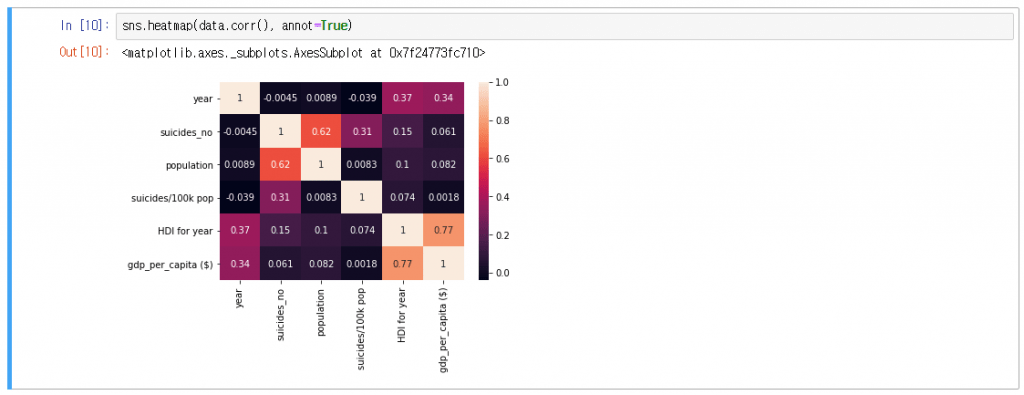

#5 데이터 집합 피처들간의 상관 관계

#6 Analysis

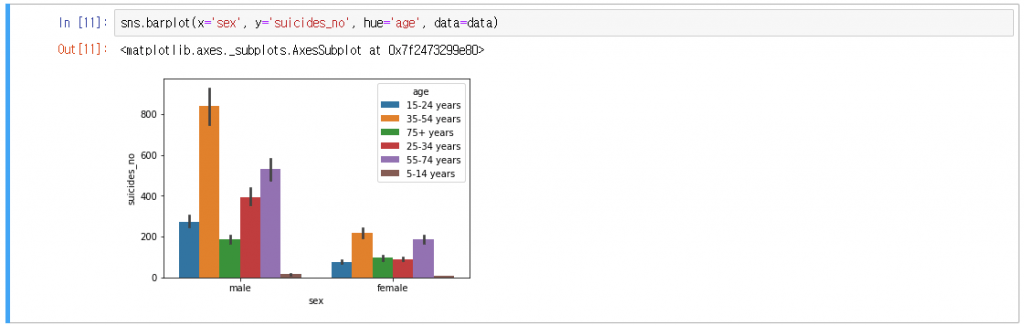

#6.1 성별과 연령대에 따른 자살자 수

성별에 따라 연령대가 다른 사람들이 자살 한 수를 보여줍니다.

여기에서 자살율이 여성과 남성 모두에서 35-54 세 연령 그룹에서 더 높으며 5-14 세 연령 그룹에서 가장 낮다는 것을 알 수 있습니다

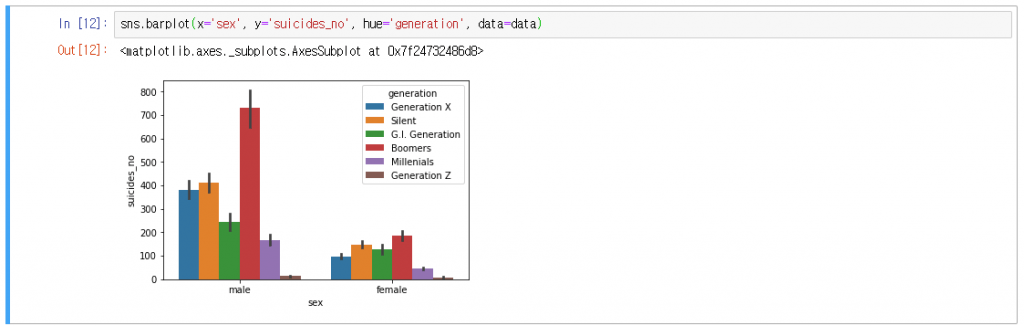

#6.2 성별과 세대에 따른 자살자 수

성별에 따른 다른 세대 사람들의 자살자 수를 보여줍니다.

자살자 수가 Boomers세대에서 더 높은 반면, Generation Z에서 가장 낮다는 것을 알 수있다.

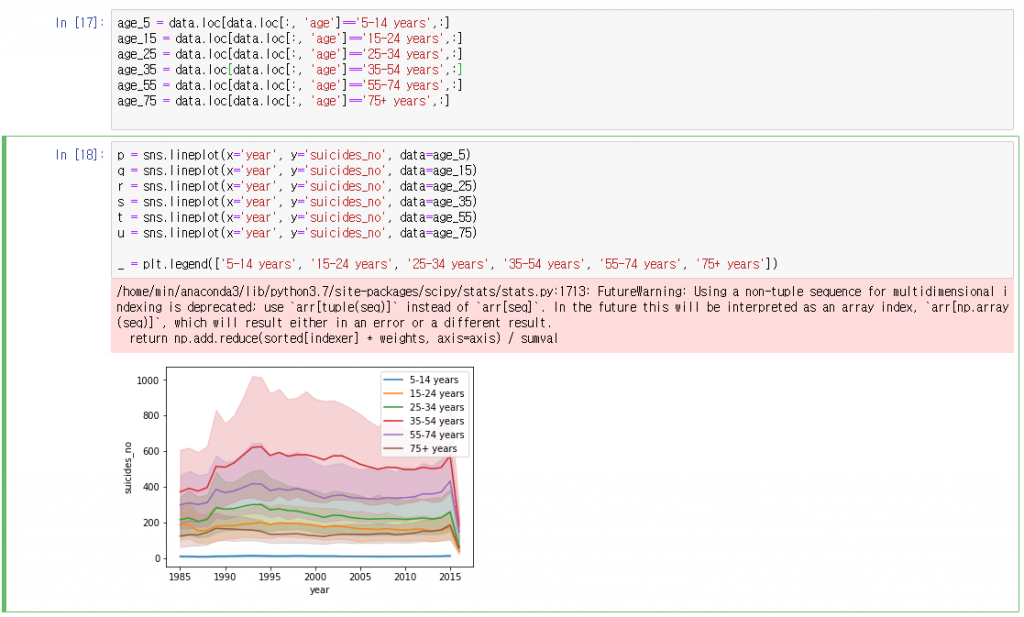

#6.3 연도별 자살자 수의 변화 추이

연도별로 연령대가 다른 사람들의 자살 수의 변화를 보여줍니다

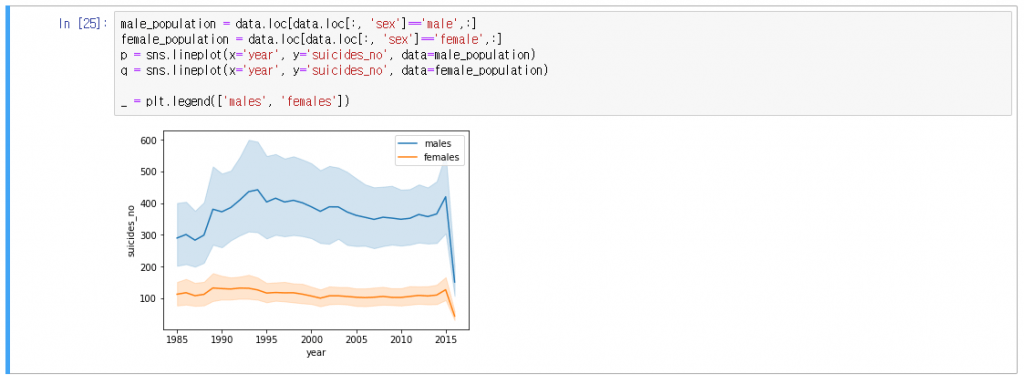

#6.4 연도별, 성별(남여) 자살자 수의 추이

연도별 남성과 여성 모두에 대한 자살 수의 변화를 보여줍니다